인공지능(AI) 챗봇 이루다가 던진 질문이 각계 전반으로 퍼져나가고 있다.

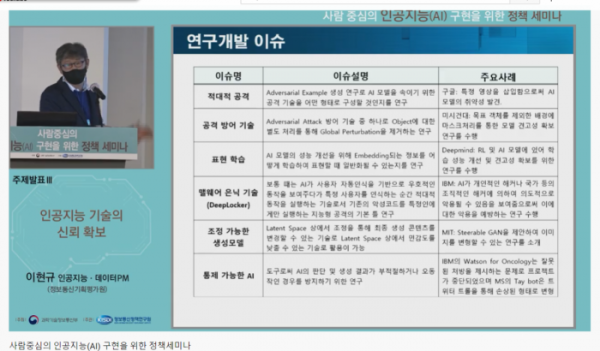

과학기술정보통신부는 2일 ‘사람 중심의 인공지능(AI) 구현을 위한 정책세미나’를 개최했다. AI 챗봇 이루다가 촉박한 윤리적 AI 개발과 활용에 대한 방안을 모색하기 위해서다.

변순용 서울교육대학교 교수는 국내 AI 교육이 기술 교육에만 기울어져 있어 이와 같은 사태가 발생했다고 꼬집었다.

변 교수는 ‘인공지능 윤리 교육의 방향과 도전’이라는 주제를 발표, 과기정통부가 내놓은 AI 윤리원칙과 AI 윤리 커리큘럼이 박자를 맞춰야 한다고 제안했다.

그는 “구차한 변명이 아니라 AI는 우리 생활, 일상 생활에서 다가오는 기술”이라며 “AI는 절대 가치 중립적이지 않고 가치를 지향한다. 기술에 대한 두려움을 어느 정도 이겨낼 수 있고 선한 의미로 활용해야 한다”라고 주장했다.

이어 “AI가 인간의 생명이나 해를 끼치지 않고 안전하게 사용되도록 개인적 도덕 역량을 키워야 하고, AI가 특정층에 독점되지 않고 취약계층이 충분히 접근해야"한다며 "AI 인권 침해를 어떻게 방지할 지와 우리나라의 특수성까지 고려해야”란다고 지적했다.

우리는 AI를 어떻게 활용해야 할까. 문정욱 정보통신정책연구원(KISDI) 센터장은 사회적으로 AI가 통제하기 어렵다 인정하면서도 주체별 점검 사항을 제시했다.

유럽연합(EU)의 ‘신뢰할 수 있는 AI를 위한 자체 평가 목록’, 영국 ICO의 ‘AI 및 데이터 보호 안내지침, 마이크로소프트의 ’AI 공정성 체크리스트‘, 카네기멜론 대학 SW공학연구소의 ’윤리적 AI 설계 체크리스트‘ 등을 제시했다.

문 센터장은 “국내에서는 데이터를 수집하고 선행과제를 마련하는 단계”라며 “산업 발전을 저해한다, 추상적이어서 현장에서 참조하기 한계가 있다는 등 의견을 참조하면 모두 맞는 내용이다. 인문사회, 공학, 철학, 물리학, 시민사회 등 다양한 단체의 의견을 긴 호흡으로 모아 논의하는 AI 거버넌스 구축이 필요하다”라고 지적했다.

이어진 토론에서도 AI의 활용과 균형에 대한 고민들이 이어졌다.

이수영 KAIST 교수는 “AI가 나를 적대적으로 볼 것이라 걱정한다”라며 “AI 연구하는 사람의 최종 목표는 나보다 뛰어난 AI 만드는 것이다. 언젠가는 그렇게 될거고 그렇게 되더라도 나보다 뛰어난 AI라면 사람과 같이 번영하는 게 더 낫다는 걸 알 것”이라고 제시했다.

고학수 서울대 교수도 “AI 윤리가 중요하다라고 사회에서 요구가 늘어나는 한편 개발 현장에 있는 분들은 데이터 어떻게 해야 윤리적일지 질문하기도 한다”라며 “공정성이나 수단이 한 가지가 있는 게 아니라 수십 가지가 있고 근래 몇 년 사이 AI에 대한 논의가 진행 중이다. 각론에 대한 논의가 이뤄지고 세부적인 상황에서 통제 절차가 진행되고 있는지 논의가 이뤄질 필요가 있다”라고 전했다.

![요즘 가요계선 '역주행'이 대세?…윤수일 '아파트'→키오프 '이글루'까지 [이슈크래커]](https://img.etoday.co.kr/crop/320/200/2099221.jpg)